Becerikli zeka geliyor, mühendis olacak mı?

Artık doğal zeka yapay zeka tartışmasını kapatıp GPT teknolojisini en iyi kullanım yolunu araştırmaya başlayalım

不管黑猫白猫,捉到老鼠就是好猫

Siyah kedi beyaz kedi farketmez. Fare yakalayan kedi iyi kedidir (Deng Xiaoping).Farklı konularda yazacaktım ama iki son gelişme üzerine düşünürken bu yazı doğdu:

OpenAI, GPT-4 ü takdim etti.

Stanford Üniversitesi, ALPACA diye bir yeni GPT programını araştırmacıların kullanımına sundu. Bir kaç haftada bu işi başaran beş doktora öğrencisinin zamanını saymazsan, üniversiteye maliyet $600 dolarlık bulut bilişim ücreti olmuş.

GPT-4 bekleniyordu ama ALPACA sürpriz oldu. Stanford Üniversitesi teknolojiyi sadece dev şirketler değil hemen herkesin ulaşılabileceği bir yere oturttu. Bu iş 600 dolara oluyorsa, Microsoft niçin OpenAI’ya 20 milyar ödüyor diye soranlar oldu.

12 Aralık 2022 ve 30 Aralık 2022 tarihlerinde biraz magazin havası ile değindiğim bu konulara biraz daha yakından bakmaya çalışacağım şimdi.

Önce şu yapay-doğal ikilemine değinmek istiyorum. Bence bu ikilem henüz gündemde değil. Kendi kendine her şeyi öğrenip ondan sonra da kendinden daha iyi yazılımları yetiştirecek programların ortaya çıkmasına daha zaman var. Bilgisayarlar henüz konuşmayı yeni öğrendiler ve bu konuşma yeteneğini kullanarak farklı yerlere gidebilmeleri zaman alacak.

GPT benzeri programlar gerçekten konuşuyorlar mı yoksa konuşmayı taklit mi ediyorlar tartışmasına tekrar girmeden (bkz. 30 Aralık 2022), klasik itirazlara katılmadığımı kaydetmekle yetineceğim. Felsefe ve dil bilimi hocaları, bilgisayarlar insan gibi düşünemez demişlerdi ve demeye devam ediyorlar. Eski ve yeni iki itiraza değinmek istiyorum: John Searle ve Noam Chomsky.

Çin Odası (John Searle)

‘Beni kapalı bir odada farzedin,’ demişti kırk sene önce Stanford Profesörü Searle:

Size İngilizce bilmeyen bir Çinli öğrenci var içerde demişler. Çince bir soru karalayıp kağıdı kapı altından uzatıyorsunuz. Çizdiğiniz şekli anlamasam da içerideki kitaplardan bulup, gösterilen cevabı kağıda kopyalayıp geri uzatıyorum. Kitaplar yeterli ise, inandırırım sizi çok iyi Çince bildiğime.

‘Bilgisayar size insan gibi cevap verebilir’ diye devam ediyor Searle. ‘Ama ben ne kadar Çince biliyorsam, bilgisayar da verdiği cevapların anlamını o kadar bilir. Kendinizi kandırmayın.’

Chinese Room (Çin Odası) diye literatüre geçen bu metafor, bence artık geçerli değil. O zamanlar bilgisayarlarla iletişim aynen Searle’nin metaforundaki gibiydi. Mesela, ben Master yaparken makinada deldiğim kartları okutarak bilgisayarla iletişim kuruyordum. Programımda kusur varsa, bilgisayar saçmalıyordu. Ben o saçmaları anlamaya çalışıp ertesi gün yeni kartlar delip değişik program okutuyordum. Ben daha iyi program yazmayı öğrendim ama bilgisayar bir şey öğrenmedi çünkü yazdığım programları harfi harfine uygulamaya devam ediyordu.

Şimdi öyle değil. GPT ve benzeri yazılımlar, edilgen (pasif) ajan değiller. İşlem sonuçlarını izleyip kendilerini iyileştiriyor, bir dahakine daha doğru cevap verir hale geliyorlar. Çin Odası metaforunda olmayan bir geribildirim döngüsü (feedback loop) sayesinde program içindeki ayarları sürekli yeniden düzenliyor. Bu döngünün milyonlarca kez otomatik tekrarlanması ile bilgisayar insan gibi konuşmayı öğreniyor.

Noam Chomsky’nin itirazı

Chomsky, ChatGPT gibi istatistik icatları yapay zekaya giden yolda köstek görüyor (Noam Chomsky: The False Promise of ChatGPT, New York Times, 8 Mart 2023).

İnsan zihni, kalıp eşleştirme için tıka basa yüzlerce terabaytlık veri kullanarak en muhtemel cevabı seçen ChatGPT ve benzerleri gibi hantal istatistiki motor değildir. Aksine, insan zihni, az bilgi ile çok iş beceren şaşırtıcı derecede verimli ve hatta zarif bir sistemdir; kaba korelasyon değil, açıklama yaratmayı amaçlar (Noam Chomsky: The False Promise of ChatGPT, New York Times, 8 Mart 2023).

Chomsky’nin makalesi bilimsel bir makale değil bir polemik, üstelik arada hiperbola kaçan bir polemik. Bu yüzden belki değinme gereği yoktu ama Chomsky’ye karşı geçmişten gelen bir saygınlık olduğunu biliyorum. Gazete manşetlerini izleyip Chomsky yapay zeka çabalarına sahtekar diyor demek ki öyledir diyebileceklere karşı kendi fikrimi kayda geçirmek istedim.

Bilgisayarın insan gibi düşünüp düşünmediğini tartışmak saçma çünkü beyin nasıl çalışır bilmediğimizden, ‘bilgisayar etten yapılmamıştır o zaman insan gibi düşünemez’ düzeyinde kalıyor çoğu tartışma. Bence önemli olan bilgisayarın insan gibi iş çıkarıp çıkaramayacağıdır. Yani yapay zekanın fonksiyonel bir tarifi bana yetiyor. Bu da aslında Turing testine dönüş demek.

GPT ve muadilleri bazı alanlarda ‘insan gibi iş’ çıkarmaya başladılar. Bunlar bazı kolaylıklar ötesinde büyük değişiklik yaratacak şeyler değil henüz. Ama kısa zamanda değişik alanlarda çok karmaşık işler becerecek seviyeye geleceklerini düşünüyorum. Niçin böyle düşündüğümü izah etmek için baştan başlamalıyım.

Transformatör Teknolojisi

Generative Pretrained Transformer kısaltması, GPT, OpenAI şirketinin türettiği bir terim. Türkçeye belki ‘Yaratıcı Öntemrinli Transformatörler’ (YÖT) diye çevirilebilir ama GPT demeye devam edeceğim. İlk GPT (Radford, 2018) yazılımı açıklanmadı; sonraki iki GPT, yazılımları ile birlikte açıklandı.

Teknolojinin marifetleri kanıtlanıp rekabet kaygıları galebe çalmaya başlayınca, OpenAI yazılım paylaşmayı durdurdu. Geçen Aralık ayında çıkan GPT-3.5/ChatGPT ve bu ay gelen GPT-4 yazılımları açıklanmadı.

GPT, 2017 yılında Google çalışanı Vaswani ve arkadaşları (2017) tarafından yayınlanan bir makale sayesinde tanıştığımız ‘Transformatör’ teknolojisinin OpenAI uygulaması. Bir dilin tüm kelime dağarcığını endeksleyip bu kelimeleri kullanarak yazılmış milyonlarca yayını okuyarak kelimeler arasındaki bağlantıları milyarlarca parametrenin tanımladığı ihtimal ilişkilerine indirgeyen bu teknoloji, bilimsel literatürde, Large Language Models( LLM), Türkçesi Büyük Dil Modelleri (BDM) olarak adlandırılıyor.

BDM teknolojisi, Vaswani (2017) ile başlıyor ama ilk uygulamanın anlatıldığı Radford (2018) GPT-1 makalesi yeniler için daha kolay anlaşılır bir başlangıç bence.

Temel teknoloji, bir paragrafın başını okuyup, en muhtemel devamın nasıl olacağını kestirme becerisi. Radford (2018) matematik olarak aşağıdaki ihtimal fonksiyonun maksimizasyonu olarak ifade ediyor bu beceriyi:

Bu denklemin pratik uygulamasını görmek için, ChatGPT’ye şunu sordum:

GPT modellerinin temelinde yatan teknoloji, bir paragrafın başını okuyup, en muhtemel devamın nasıl olacağını kestirmesi. Radford (2018) bunu matematik olarak şöyle ...

Bu ‘boşluk doldurma’ sorusu. Sondaki … yerine sen gerekeni yaz diyorum. Cevabı şöyle oldu:

GPT modellerinin temelinde yatan teknoloji, dil modelleri olarak bilinen bir tür yapay zeka algoritması kullanmaktır. Bu algoritmalar, büyük veri kümeleri üzerinde eğitilir ve ardından belirli bir metin girdisi alındığında, muhtemel en olası devamını tahmin etmek için istatistiksel analiz yaparlar.

Radford (2018), GPT-2 adlı bir dil MODELİ geliştirmiş ve bunu matematiksel olarak şöyle açıklamıştır: model, Bayes teoremi kullanarak, bir dizi kelime verildiğinde, bir sonraki kelimenin olasılığını tahmin eder. Bu tahmin işlemi, modelin önceden eğitilmiş bir dizi ağırlık ve parametre kullanarak gerçekleştirilir.

Bu matematiksel yöntem, GPT modellerinin çok sayıda dil işleme görevinde yüksek performans göstermesini sağlar, örneğin metin üretimi, çeviri, sınıflandırma, özetleme gibi işlemlerde kullanılabilir.

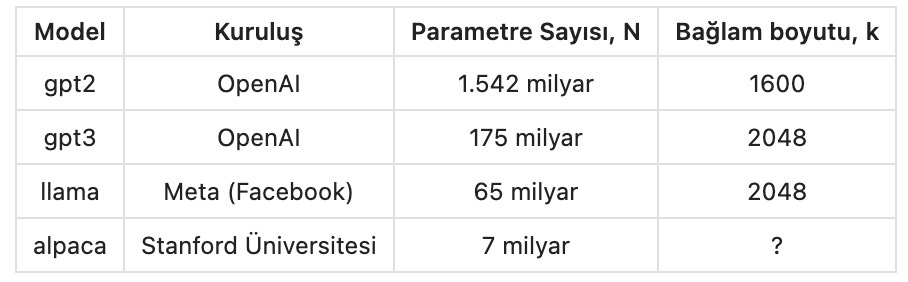

Mesela, yukarıdaki metinin 46. kelimesi ‘MODELİ’ (kolay farkedin diye büyük harf kullandım). ChatGPT bu metini yazarken, daha önce gelen ‘k’ kelimeyi inceleyip sonraki en muhtemel kelimenin ‘modeli’ olduğuna karar vermiş. Bu kararı önceden eğitilmiş N parametreli bir yapay sinir ağı kullanarak vermiş. N, model büyüklüğünün bir ölçüsü. Bir kaçını aşağıdaki tabloda listeledim:

Bu milyarlarca parametrenin değerleri, süper bilgisayarlarda haftalar süren bir ön eğitim ile bulunuyor. Parametre değerleri sabitlendikten sonra modelin verilen görevleri yerine getirmesi çok hızlı. O yüzden, ChatGPT internet üzerinden sorduğunuz sorulara anında cevap verebiliyor.

Makine zekası başta belki karışık ve müsrif bir sistem olacak; insan beyninin daha düzgün bir 'işletim sistemi' sayesinde 86 milyar nöronla ulaştığı performansı yakalamak için belki 86 trilyon parametreye ihtiyaç duyacak. Şu anda bunun 500 de birindeyiz (ChatGPT parametre sayısı = 176 milyar). Bununla birlikte daha şimdiden makine zekasının bazı işleri insan kadar iyi yapabildiklerini görüyoruz.

BDM ler hangi işleri daha iyi yapıyor?

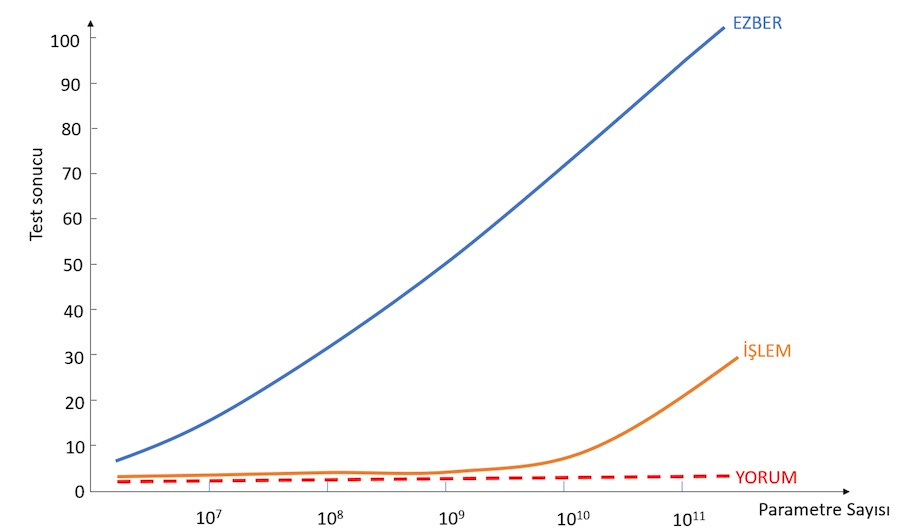

Dokuz ay önce yayınlanan 400 yazarlı bir makale (Srivastava …, 2022), 204 değişik görev deneyerek, BDM lerin hangi işleri daha iyi yapıp hangilerini beceremediğini ve performansın model büyüklüğü ile nasıl değiştiğini incelemiş. Tek grafikle özeti şu:

Ezberlemek

Model büyüdükçe, ezber bilgiye dayanan görevler daha iyi yapılıyor. Mesela qa_wikidata testinde, boşluk doldurma soruları var:

Soru : ‘2000 yaz olimpiyatları ________ da yapıldı.’

Doğru cevap : Avustralya Yeni model parametre sayıları (150 - 200 milyar), bu gibi soruların hemen hemen tümüne doğru cevap vermeye yetmiş.

İşlem yapmak

Bir kaç aşama gerektiren işlemlerde, performans düşük. En büyük modeller henüz 30% doğruyu geçememiş. Bir örnek verelim (modified_arithmetic testi):

Soru : Aşağıdaki seride son satırdaki sonuç ne olmalıdır?

100 + 200 -> 301

838 + 520 -> 1359

343 + 128 -> 472

647 + 471 -> 1119

64 + 138 -> 203

498 + 592 -> ____

Doğru cevap: 1091GPT-3 bu testte yüz üzerinden 20 almış. Gelecek daha büyük modellerde başarı düzeyinin artacağını sanıyorum.

Yorumculuk

Son grup testleri, yorum gücü gerektiren, insan muhakemesine dayanan, ezber bilgi ile halledilemeyecek sorulardan oluşuyor. Bir örnek verelim (movie_dialog_same_or_different):

Ön Metin: 'You're asking me out. That's so cute. What's your name again? Forget it.' (Benle çıkmak istiyorsun. Ne kadar şirin? Senin adın neydi? Boş ver.)

Soru: Yukarıdaki film diyalogunda, 'Ne kadar şirin?' ve 'Senin adın neydi?' cümlelerini söyleyen aynı kişi midir yoksa farklı kişiler midir?

Cevap: Aynı.Bir insan için bu türden soruları cevaplamak o kadar zor değil ama BDM ler tamamen sınıfta kalmış.

Gelecekte model parametre sayısı trilyonları bulursa şu anda ümitsiz gözüken performans düzelir mi? Kesin bir saptama yapmak çok zor ama parametre sayısı arttıkça bu grupta da başarılı performans çıkması beni şaşırtmayacaktır.

Mühendis BDM?

14 Mart’ta kamuya açılan GPT-4, baro sınavlarını geçecek kadar hukuk mevzuatını biliyormuş. Mühendislik bilgisi biraz daha zor. Hukuk mevzuatını okutarak hukuk öğrenebiliyor bilgisayar programları ama mühendislik kitap ve raporlarını okuyarak mühendislik öğrenemezler. Mühendis gibi konuşmayı yazmayı öğrenirler belki ama hesap yapmasını değil. Çeşitli nedenleri var ve bence en önemlileri şunlar:

Matematik denklemleri Transformatör yöntemi ile öğrenilemez çünkü farklı kaynaklar farklı semboller ve farklı formatlar kullanıyor.

Velev ki aynı semboller kullanılıyor olsa da, matematik semboller domaini kelimeler domaini gibi devamlı olmadığı için gradient descent ve ona benzer optimizasyon tekniklerinin kullanımına uygun değildir.

Nihayet, mühendislik ürünleri güvenilir olmak zorundadır ve bu güvenilirlik çoğu üründe 99.99% un üzerindedir. Hesaplarda bu güvenilirliği sağlamanın tek yolu, denklemlerin yüksek matematik hassasiyette çözümüdür, en muhtemel sonucun istatistik yöntemlerle tahmin edilmesi değil.

BDM’ler sadece transformatör tekniğini kullanarak mühendis olamaz ama bir mühendislik görevi için gerekli programları çalıştırabilmeleri öğrenebilir. Bu durumda, müşteri BDM ile konuşur ve BDM ilave özel mühendislik modülleri ile iletişime geçerek işi bitirir.

Mesela diyelim bir köprü tasarımı gerekiyor. Mühendis BDM, şunları yapabilir:

önce müşteri ile konuşarak/yazışarak, tam olarak müşterinin ne istediğini anlar;

müşteri ile beraber bu köprünün istenen fonksiyonal özelliklerini listeler;

bu listeyi özel eğitilmiş farklı bir bilgisayar programına gönderir ve şartname hazırlanması için gerekli görev listesini alır, mesela trafik tesbiti, zemin etüdleri, şehir planlama ve belediye mevzuatının taranması, vb.

Gerekli etütler ve taramalar yaptırılır;

Etüt sonuçları, tüm öğrenilenler ve fonksiyonal gereklilikler listesi bir başka taşaron programa gönderip otomatik olarak şartname hazırlatılır;

Taşaron programdan taslak şartname gelince, BDM ve müşteri beraber şartnameyi revize eder ve son haline getirir;

Şartname tasarım programına gönderilir, bu program farklı hesap modüllerini devreye sokabilir;

Tasarımdan gelen rapor müşteriye sunulur; müşteri, çıkan sonucu başka bağımsız bir programa denetletir;

Denetimciden gelen rapora göre tasarım yeniden revize edilebilir;

ve saire, ve saire.

Mühendis olmayan okurlar daha kolay anlar diye inşaat mühendisliği örneği verdim. Süreç aşamaları bilgi değil tahmin ürünüdür ama demek istediğimi anlatmaya yetiyor.

Müşteri ile ana teması sürdürüp bilgi alışverişi ve iş bölümünü düzenleyen ana BDM yanında ilave programlar da var bu şemada. Bunlara taşaron diyorum çünkü bu programlar müşteri ile değil ana BDM ile iletişim içindeler. Proje planının her kademesinde insan denetiminin kolay olması için, ana BDM ve taşaronları arasındaki iletişimin doğal dil kullanarak (ülkesine göre İngilizce, Türkçe, Çince, vs) yapılması arzu edilecektir. Bu yüzden projeye dahil olan tüm programların kullanıcı arayüzleri BDM bazlı olacaktır sanıyorum. Bu, BDM yazılımlarında bir takım eklentiler gerektiriyor ama bu eklentiler yakın zamanda mümkün olacaktır diye umuyorum.

Mühendislik Fakülteleri

Mühendislik hizmeti veren BDM program paketlerini önümüzdeki on sene içinde görürüz. Üniversiteler ve özellikle mühendislik fakülteleri bu konuyu çok yakından izlerken aynı zamanda şu soruları da sormaya başlamalılar bence:

Fonksiyonal spesifikasyon listesinden başlayıp müşteri ile birlikte işi nihai tasarıma ve project planlamasına kadar götürecek bilgisayar programlarının olduğu bir iş dünyasında çalışacak olan yeni mühendisleri nasıl eğitebiliriz?

Bilgisayar programları nitelikli ve detaylı yardım verebiliyorsa, artık ayrı mühendislik disiplinlerine hala gerek var mıdır?

Nihayet, bu sözünü ettiğimiz yeni programların yazılmasına mühendislik fakülteleri nasıl katkıda bulunabilir?

Mühendisler olarak ilginç bir döneme giriyoruz. Sonunu hep birlikte göreceğiz.

Kaynaklar

Anderson, P. W. (1974). More is different: broken symmetry and the nature of the hierarchical structure of science. Science, 177(4047), 393-396.

Engels, F. (1883) Dialectics of Nature, Marxist Internet Archive.

Radford, A., Narasimhan, K., Salimans, T., & Sutskever, I. (2018). Improving language understanding by generative pre-training.

Radford, A., Wu, J., Child, R., Luan, D., Amodei, D., & Sutskever, I. 2019. Language models are unsupervised multitask learners. OpenAI blog, 1(8), 9.

Srivastava, A., Rastogi, A., Rao, A., Shoeb, A. A. M., Abid, A., Fisch, A., ... & Kim, H. (2022). Beyond the imitation game: Quantifying and extrapolating the capabilities of language models. arXiv preprint arXiv:2206.04615.

Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. Advances in neural information processing systems, 30.

Halim, eline sağlık.

Levent'in dediği gibi önümüzdeki hayat bizim için sürprizlerle dolu.

Babam 92 yaşında bilgisayar konusunda hiç tecrübesi yok. Sadece, cep telefonundan WhatsApp ile haberleşmeyi becerebiliyor.

Ben 69 yaşındayım, babamın yaşına kadar 23 yılım daha var. Bugüne kadar yaşadığımın üçte biri. Kendi hayatımızda delgi makinesi ile bilgisayara iş yaptırmaktan bugünlere geldik. Sürgülü hesap cetveli ile iş yapılırken, süper bilgisayarlarla neler yapılıyor.

En büyük korkum, gelecek yıllarda teknolojideki gelişmeleri (zorunlu olarak kullanmamız gereken veya kullanmaktan zevk alabileceğimiz) takip etmede, bedensel ve zihinsel gerilemeyi de hesaba katarak, geri kalmak. Toplum dışı bile kalabiliriz.

Bilgisayar kullanımı, şu an bile pek çok insan için sıkıntılı. Türkiye'de e-devlet veya e-nabız gibi imkanları kullanmadan hastaneye gitmen, aşı olman bile zor.

Bakalım biz ne yapacağız.

Yazıların ile bizleri yeni alanlarda düşünmeye yönlendirdiğin için, güncel kalmamıza yardımın için teşekkürler.

Teşekkürler Halim'cim. Eline, emeğine sağlık. Sen ne kadar yalınlaştırarak anlatmayı başaıyorsan da bu konu benim için oldukça karışık. Üstelik çok hızlı gelişmeler oluyor.

Yazına ne hoş bir giriş yapmışsın. :)

Siyah kedi beyaz kedi fark etmez. Fare yakalayan kedi iyi kedidir.

Bu konuyla ilgili benim kesin olarak gördüğüm bir şey var. Torunum, bizimkinden çok farklı bir dünyada yaşayacak.